Студопедия КАТЕГОРИИ: АвтоАвтоматизацияАрхитектураАстрономияАудитБиологияБухгалтерияВоенное делоГенетикаГеографияГеологияГосударствоДомЖурналистика и СМИИзобретательствоИностранные языкиИнформатикаИскусствоИсторияКомпьютерыКулинарияКультураЛексикологияЛитератураЛогикаМаркетингМатематикаМашиностроениеМедицинаМенеджментМеталлы и СваркаМеханикаМузыкаНаселениеОбразованиеОхрана безопасности жизниОхрана ТрудаПедагогикаПолитикаПравоПриборостроениеПрограммированиеПроизводствоПромышленностьПсихологияРадиоРегилияСвязьСоциологияСпортСтандартизацияСтроительствоТехнологииТорговляТуризмФизикаФизиологияФилософияФинансыХимияХозяйствоЦеннообразованиеЧерчениеЭкологияЭконометрикаЭкономикаЭлектроникаЮриспунденкция |

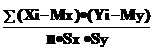

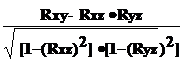

Корреляция случайных величинПрямое токование термина корреляция — стохастическая, вероятная, возможная связь между двумя (парная) или несколькими (множественная) случайными величинами. Выше говорилось о том, что если для двух СВ (XиY) имеет место равенство P(XY) =P(X) Ведь всегда важен вопрос — а как сильно зависит одна СВ от другой? И дело в не присущем людям стремлении анализировать что-либо обязательно в числовом измерении. Уже понятно, что системный анализ означает непрерывные вычисления, что использование компьютера вынуждает нас работать с числами, а не понятиями. Для числовой оценки возможной связи между двумя случайными величинами: Y(со средним Myи среднеквадратичным отклонением Sy) и — X (со средним Mx и среднеквадратичным отклонением Sx) принято использовать так называемый коэффициент корреляции Rxy= Этот коэффициент может принимать значения от -1 до +1 — в зависимости от тесноты связи между данными случайными величинами. Если коэффициент корреляции равен нулю, то X и Y называют некоррелированными. Считать их независимыми обычно нет оснований — оказывается, что существуют такие, как правило — нелинейные связи величин, при которых Rxy = 0, хотя величины зависят друг от друга. Обратное всегда верно — если величины независимы, то Rxy = 0. Но, если модуль Rxy = 1, то есть все основания предполагать наличие линейной связи между Y и X. Именно поэтому часто говорят о линейной корреляции при использовании такого способа оценки связи между СВ. Отметим еще один способ оценки корреляционной связи двух случайных величин — если просуммировать произведения отклонений каждой из них от своего среднего значения, то полученную величину —  Сxy= S (X - Mx)·(Y - My) или ковариацию величин X и Yотличает от коэффициента корреляции два показателя: во-первых, усреднение (деление на число наблюдений или пар X, Y) и, во-вторых, нормирование путем деления на соответствующие среднеквадратичные отклонения. Такая оценка связей между случайными величинами в сложной системе является одним из начальных этапов системного анализа, поэтому уже здесь во всей остроте встает вопрос о доверии к выводу о наличии или отсутствии связей между двумя СВ. В современных методах системного анализа обычно поступают так. По найденному значению R вычисляют вспомогательную величину: W = 0.5 Ln[(1 + R)/(1-R)] {2 - 12} и вопрос о доверии к коэффициенту корреляции сводят к доверительным интервалам для случайной величины W, которые определяются стандартными таблицами или формулами. В отдельных случаях системного анализа приходится решать вопрос о связях нескольких (более 2) случайных величин или вопрос о множественной корреляции. Пусть X, Y и Z - случайные величины, по наблюдениям над которыми мы установили их средние Mx, My,Mz и среднеквадратичные отклонения Sx, Sy, Sz. Тогда можно найти парные коэффициенты корреляции Rxy, Rxz, Ryz по приведенной выше формуле. Но этого явно недостаточно - ведь мы на каждом из трех этапов попросту забывали о наличии третьей случайной величины! Поэтому в случаях множественного корреляционного анализа иногда требуется отыскивать т. н. частные коэффициенты корреляции — например, оценка виляния Z на связь между X и Y производится с помощью коэффициента Rxy.z = И, наконец, можно поставить вопрос — а какова связь между данной СВ и совокупностью остальных? Ответ на такие вопросы дают коэффициенты множественной корреляции Rx.yz, Ry.zx, Rz.xy, формулы для вычисления которых построены по тем же принципам — учету связи одной из величин со всеми остальными в совокупности. На сложности вычислений всех описанных показателей корреляционных связей можно не обращать особого внимания - программы для их расчета достаточно просты и имеются в готовом виде во многих ППП современных компьютеров. Достаточно понять главное — если при формальном описании элемента сложной системы, совокупности таких элементов в виде подсистемы или, наконец, системы в целом, мы рассматриваем связи между отдельными ее частями, — то степень тесноты этой связи в виде влияния одной СВ на другую можно и нужно оценивать на уровне корреляции.

В заключение заметим еще одно — во всех случаях системного анализа на корреляционном уровне обе случайные величины при парной корреляции или все при множественной считаются "равноправными" — т. е. речь идет о взаимном влиянии СВ друг на друга. Так бывает далеко не всегда - очень часто вопрос о связях Y и X ставится в иной плоскости — одна из величин является зависимой (функцией) от другой (аргумента).

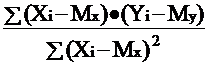

Линейная регрессия В тех случаях, когда из природы процессов в системе или из данных наблюдений над ней следует вывод о нормальном законе распределения двух СВ - Y и X, из которых одна является независимой, т. е. Y является функцией X, то возникает соблазн определить такую зависимость “формульно”, аналитически. В случае успеха нам будет намного проще вести системный анализ — особенно для элементов системы типа "вход-выход”. Конечно, наиболее заманчивой является перспектива линейной зависимости типа Y = a + b·X . Подобная задача носит название задачи регрессионного анализа и предполагает следующий способ решения. Выдвигается следующая гипотеза: H0: случайная величина Y при фиксированном значении величины X распределена нормально с математическим ожиданием My = a + b·X и дисперсией Dy, не зависящей от X. {2 - 14} При наличии результатов наблюдений над парами Xi и Yi предварительно вычисляются средние значения My и Mx, а затем производится оценка коэффициента b в виде b = что следует из определения коэффициента корреляции {2 - 11}. После этого вычисляется оценка для a в виде a = My - b и производится проверка значимости полученных результатов. Таким образом, регрессионный анализ является мощным, хотя и далеко не всегда допустимым расширением корреляционного анализа, решая всё ту же задачу оценки связей в сложной системе.

|

||

|

Последнее изменение этой страницы: 2018-04-12; просмотров: 550. stydopedya.ru не претендует на авторское право материалов, которые вылажены, но предоставляет бесплатный доступ к ним. В случае нарушения авторского права или персональных данных напишите сюда... |

P(Y), то величины Xи Y считаются независимыми. Ну, а если это не так!?

P(Y), то величины Xи Y считаются независимыми. Ну, а если это не так!? . {2 - 11}

. {2 - 11}  {2 - 13}

{2 - 13}

= Rxy

= Rxy  {2 - 15}

{2 - 15}