Студопедия КАТЕГОРИИ: АвтоАвтоматизацияАрхитектураАстрономияАудитБиологияБухгалтерияВоенное делоГенетикаГеографияГеологияГосударствоДомЖурналистика и СМИИзобретательствоИностранные языкиИнформатикаИскусствоИсторияКомпьютерыКулинарияКультураЛексикологияЛитератураЛогикаМаркетингМатематикаМашиностроениеМедицинаМенеджментМеталлы и СваркаМеханикаМузыкаНаселениеОбразованиеОхрана безопасности жизниОхрана ТрудаПедагогикаПолитикаПравоПриборостроениеПрограммированиеПроизводствоПромышленностьПсихологияРадиоРегилияСвязьСоциологияСпортСтандартизацияСтроительствоТехнологииТорговляТуризмФизикаФизиологияФилософияФинансыХимияХозяйствоЦеннообразованиеЧерчениеЭкологияЭконометрикаЭкономикаЭлектроникаЮриспунденкция |

Обработка больших объёмов данных.Из названия можно предположить, что термин `большие данные` относится просто к управлению и анализу больших объемов данных. Согласно отчету McKinsey Institute `Большие данные: новый рубеж для инноваций, конкуренции и производительности` (Big data: The next frontier for innovation, competition and productivity), термин `большие данные` относится к наборам данных, размер которых превосходит возможности типичных баз данных (БД) по занесению, хранению, управлению и анализу информации. Тем не менее `большие данные` предполагают нечто большее, чем просто анализ огромных объемов информации. Проблема не в том, что организации создают огромные объемы данных, а в том, что бóльшая их часть представлена в формате, плохо соответствующем традиционному структурированному формату БД, — это веб-журналы, видеозаписи, текстовые документы, машинный код или, например, геопространственные данные. Всё это хранится во множестве разнообразных хранилищ, иногда даже за пределами организации. В результате корпорации могут иметь доступ к огромному объему своих данных и не иметь необходимых инструментов, чтобы установить взаимосвязи между этими данными и сделать на их основе значимые выводы. Добавьте сюда то обстоятельство, что данные сейчас обновляются все чаще и чаще, и вы получите ситуацию, в которой традиционные методы анализа информации не могут угнаться за огромными объемами постоянно обновляемых данных, что в итоге и открывает дорогу технологиям больших данных. В сущности понятие больших данных подразумевает работу с информацией огромного объема и разнообразного состава, весьма часто обновляемой и находящейся в разных источниках в целях увеличения эффективности работы, создания новых продуктов и повышения конкурентоспособности. Консалтинговая компания Forrester дает краткую формулировку: `Большие данные объединяют техники и технологии, которые извлекают смысл из данных на экстремальном пределе практичности.  Большие данные — это совокупность технологий, которые призваны совершать три операции. Во-первых , обрабатывать большие по сравнению со «стандартными» сценариями объемы данных. Во-вторых , уметь работать с быстро поступающими данными в очень больших объемах. То есть данных не просто много, но их постоянно становится все больше и больше. В-третьих , они должны уметь работать со структурированными и плохо структурированными данными параллельно в разных аспектах. Большие данные предполагают, что на вход алгоритмы получают поток не всегда структурированной информации и что из него можно извлечь больше, чемкакую-то одну идею. Big Data Сегодня наблюдается большой интерес к технологиям класса BIG DATA, связанный с постоянным ростом данных, которыми приходится оперировать крупным компаниям. Накопленная информация для многих организаций является важным активом, однако обрабатывать ее и извлекать из нее пользу с каждым днем становится все сложнее и дороже.

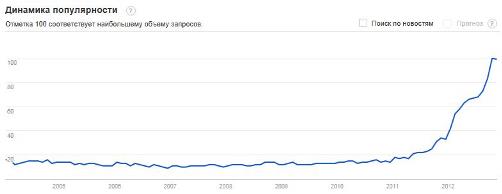

Рис. 1. Динамика запросов по «Big Data» от Google Так в чем же секрет популярности этих технологий и что означает термин «Big Data»? В первую очередь, под терминами "Big Data", "Большие данные" или просто "биг дата" скрывается огромный набор информации. Причем объем ее столь велик, что обработка больших объемов данных стандартными программными и аппаратными средствами представляется крайне сложной. Другими словами, Big Data – это проблема. Проблема хранения и обработки гигантских объемов данных. С другой стороны, обработка больших объемов информации – это только часть «айсберга». Как правило, когда говорят о термине "биг дата", то используют наиболее популярное определение трех «V», что означает Volume – объем данных, Velocity – необходимость обрабатывать информацию с большой скоростью и Variety – многообразие и часто недостаточную структурированность данных. Например, время операции по проверке баланса на карте при снятии наличных исчисляется в миллисекундах. Именно такие требования диктует рынок. Третья сторона вопроса – это разнообразие и неструктурированность информации. Все чаще и чаще приходится оперировать медиа контентом, записями в блогах, слабо структурированными документами и т.д. Таким образом, когда мы говорим о big data, мы понимаем, что это связано с тремя аспектами: большим объемом информации, ее разнообразием или необходимостью обрабатывать данные очень быстро. С другой стороны, под этим термином часто понимают совершенно конкретный набор подходов и технологий, призванных решить данные задачи. В основе одного из таких подходов лежит система распределенных вычислений, где обработка больших объемов данных требует для себя не одну высокопроизводительную машина, а целую группу таких машин, объединенных в кластер. Парадигма Big Data определяет три основных типа задач. Хранение и управление объемом данных в сотни терабайт или петабайт, которые обычные реляционные базы данных не позволяют эффективно использовать. Организация неструктурированной информации, состоящей из текстов, изображений, видео и других типов данных. Анализ Big Data, который ставит вопрос о способах работы с неструктурированной информацией, генерацию аналитических отчетов, а также внедрение прогностических моделей. Рынок проектов Big Data пересекается с рынком бизнес-аналитики (BA), объем которого в мире, по оценкам экспертов, в 2015 году составил свыше 100 млрд. долларов. Он включает в себя компоненты сетевых технологий, серверов, программного обеспечения и технических услуг. Также использование технологий Big Data актуально для решений класса гарантирования доходов (RA), предназначенных для автоматизации деятельности компаний. Современные системы гарантирования доходов включают в себя инструменты обнаружения несоответствий и углубленного анализа данных, позволяющие своевременно обнаружить возможные потери, либо искажение информации, способные привести к снижению финансовых результатов. На этом фоне казахстанские компании, подтверждающие наличие спроса технологий Big Data на отечественном рынке, отмечают, что факторами, которые стимулируют развитие Big Data в РК, являются рост данных, ускорение принятия управленческих решений и повышение их качества. Data Mining. Интеллектуальный анализ данных (Data Mining) Термин «Data Mining» переводится как «извлечение информации» или «добыча данных». Цель Data Mining состоит в выявлении скрытых правил и закономерностей в наборах данных. Результатом такого метода обработки данных являются эмпирические модели, классификационные правила, выделенные кластеры и т.д. Этапы исследования данных с помощью методов Data Mining Основные этапы, или шаги, которые, как правило, входят в любое исследование данных с помощью методов Data Mining: Приведение данные к форме, пригодной для применения конкретных реализаций систем Data Mining. Выходом данного этапа должны быть структурированные данные в виде прямоугольной таблицы, где каждая строка представляет собой отдельный случай, объект или состояние изучаемого объекта, а каждая колонка – параметры, свойства или признаки всех исследуемых объектов. Строки подобной таблицы в теории Data Mining, как и в теории баз данных принято называть записями, а колонки – полями. Предварительная обработка данных с одинаковыми значениями для всех колонок. Например, “очистка” данных по столбцам и строкам таблицы по признакам. Любая реальная база данных обычно содержит ошибки, очень неточно определенные значения, записи, соответствующие каким-то редким, исключительным ситуациям, и другие дефекты, которые могут резко понизить эффективность методов Data Mining, применяемых на следующих этапах анализа. Применение методов Data Mining. Сценарии этого применения могут быть самыми различными и включать сложную комбинацию разных методов, особенно если используемые методы позволяют проанализировать данные с разных точек зрения. Собственно этот этап исследования и принято называть Data Mining (дословно, «разработка данных»). |

||

|

Последнее изменение этой страницы: 2018-05-10; просмотров: 536. stydopedya.ru не претендует на авторское право материалов, которые вылажены, но предоставляет бесплатный доступ к ним. В случае нарушения авторского права или персональных данных напишите сюда... |